扫码可加入免费ChatGpt4交流群。

扫码可加入免费ChatGpt4交流群。

就在今日凌晨1点,OpenAI举行了春季发布会,发布了GPT-4o 并免费提供更多功能。

亲测GPT-4o已经可以免费试用,每个人都可以使用它并从中受益,GPT4终于不再是少部分人的玩物。

根据使用情况和需求,免费用户可以使用 GPT-4o 发送的消息数量会受到限制。当达到限制时,ChatGPT 将自动切换到 GPT-3.5,以便用户可以继续对话。

发布GPT-4o模型

GPT-4o 是OpenAI最新的旗舰型号,它提供 GPT-4 级别的智能,但速度更快,并改进了其跨文本、语音和视觉的功能。

它是迈向更自然的人机交互的一步——接受文本、音频和图像的任意组合作为输入,并生成文本、音频和图像的任意组合输出。

更快的响应

它可以在短至 232 毫秒的时间内响应音频输入,平均为 320 毫秒,这与人类在对话中的响应时间相似。它在英语文本和代码上的性能与 GPT-4 Turbo 的性能相匹配,在非英语文本上的性能显着提高,同时 API 的速度也更快,成本降低了 50%。与现有模型相比,GPT-4o 在视觉和音频理解方面尤其出色。

多模态聊天

GPT-4o把文本、视觉和音频端到端地训练了一个新模型,这意味着所有输入和输出都由同一神经网络处理。

所以它可以直接观察音调、多个说话者或背景噪音,也可以输出笑声、歌唱或表达情感

情感聊天:gpt可以听懂你的语气和背景音,并直接合成具有情感的语音恢复,不再需要将文本转换成语音。

不间断聊天:你可以在gpt说话的同时,继续提问,或打断它说话,跟两个人聊天完全一样,完全不需要进行等待,此功能目前只有GPT具有。此功能可用于同声传译。

视频聊天:你可以开始摄像头和gpt聊天,gpt能识别视屏并基于视频内容回复。

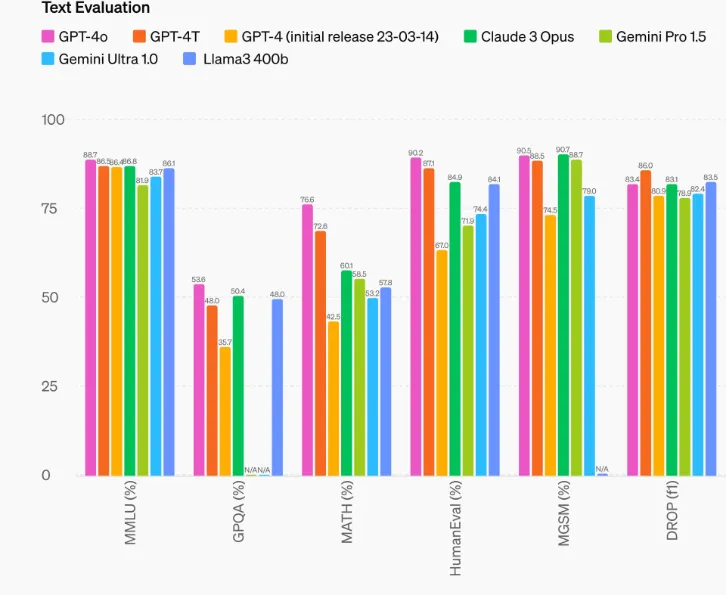

模型评估

根据传统基准测试,GPT-4o 在文本、推理和编码智能方面实现了 GPT-4 Turbo 级别的性能,同时在多语言、音频和视觉功能上设置了新的高水位线。

模型可用性

GPT-4o 的文本和图像功能今天开始在 ChatGPT 中推出。我们正在免费套餐中提供 GPT-4o,并向 Plus 用户提供高达 5 倍的消息限制。

未来几周内,我们将在 ChatGPT Plus 中推出新版语音模式 GPT-4o 的 alpha 版。

开发人员现在还可以在 API 中访问 GPT-4o 作为文本和视觉模型。与 GPT-4 Turbo 相比,GPT-4o 速度提高 2 倍,价格降低一半,速率限制提高 5 倍。我们计划在未来几周内在 API 中向一小群值得信赖的合作伙伴推出对 GPT-4o 新音频和视频功能的支持。

发布更多免费功能

使用 GPT-4o 时,ChatGPT 免费用户现在可以访问以下功能:

- 体验GPT-4级智能

- 从模型和网络获取响应

- 分析数据和创建图表

- 上传照片进行聊天

- 上传文件以帮助总结、写作或分析

- 使用 GPTS 和 GPT 商店

- 使用 Memory 打造更有帮助的体验

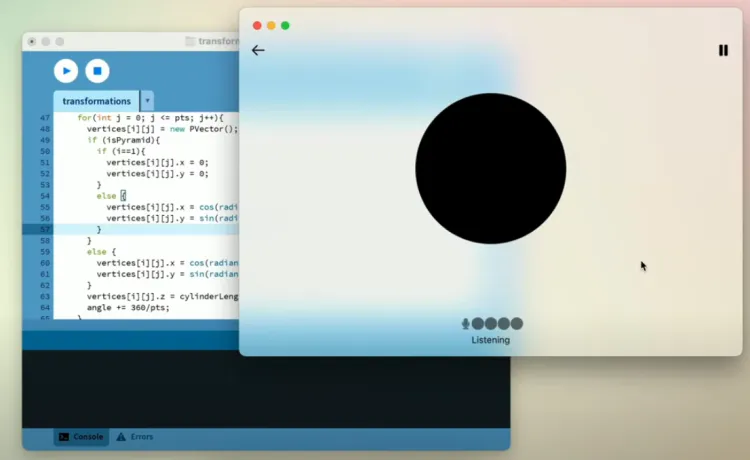

发布PC端ChatGPT

对于免费和付费用户,OpenAI还推出了适用于 macOS 的新 ChatGPT 桌面应用程序,该应用程序旨在无缝集成到您在计算机上执行的任何操作。

通过简单的键盘快捷键(Option + Space),您可以立即向 ChatGPT 提问。

PC端ChatGPT目前功能还非常简单,只支持聊天和屏幕共享。

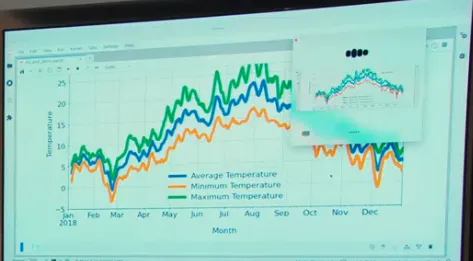

GPT可以读取共享的屏幕内容,并可以基于屏幕内容进行聊天。

我认为这可能是ChatGPT成为PC助手的第一步。

仅目前的功能应用场景就很广,如:

屏幕打开代码编辑器:chatgpt可以帮你解释代码,提供编程建议等;

屏幕打开Excel软件:chatgpt可以帮你分析表格图标和数据趋势,手把手教你处理数据。

从今天开始,OpenAI将向 Plus 用户推出 macOS 应用程序,并将在未来几周内更广泛地提供该应用程序。我们还计划在今年晚些时候推出 Windows 版本。

新的外观

OpenAI为 ChatGPT 引入了新的外观和感觉,旨在更加友好和更具对话性。您会注意到新的主屏幕、消息布局等。